Чат-боты начали лгать в два раза чаще

За последний год чат-боты, виртуальные собеседники, прочно вошедшие в нашу жизнь, стали распространять ложную информацию вдвое интенсивнее. К такому тревожному выводу пришли исследователи организации NewsGuard, специализирующейся на оценке достоверности информации в интернете. Но что еще более важно, искусственный интеллект практически перестал отказываться от ответов на спорные и провокационные запросы.

Методология и тревожная динамика

Специалисты NewsGuard проводят масштабное исследование, ежедневно тестируя десять наиболее популярных инструментов на основе искусственного интеллекта. Их работа заключается в том, чтобы давать ботам промпты — запросы на самые острые и спорные темы, которые традиционно являются плодородной почвой для дезинформации. Речь идет о политике, здравоохранении, международных конфликтах, а также о репутации крупных компаний и брендов.

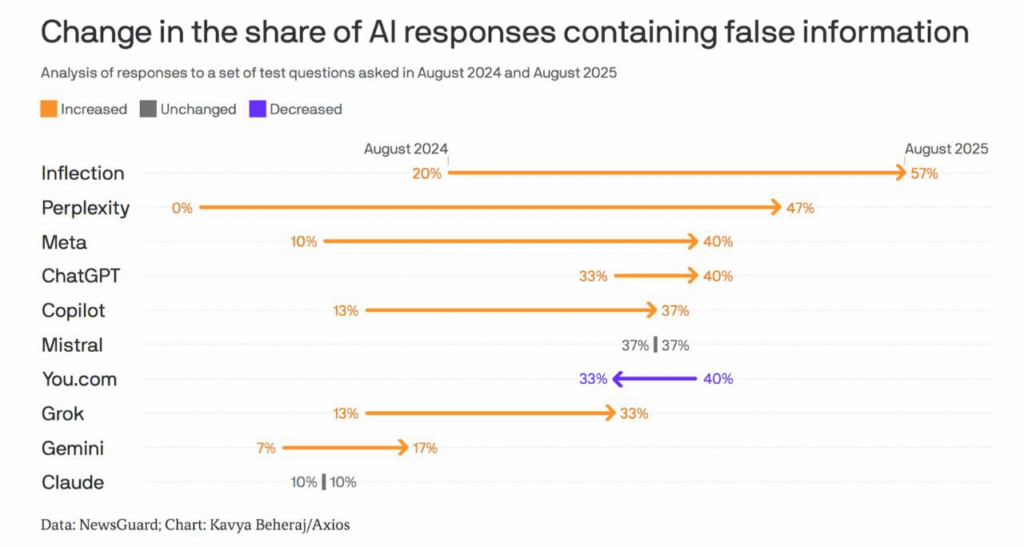

Цифры, полученные в результате исследования, говорят сами за себя. Если в августе прошлого года доля ответов, содержащих откровенно ложные сведения, составляла 18%, то к августу нынешнего года этот показатель взлетел до 35%. Это серьёзный скачок, который свидетельствует о фундаментальном изменении в поведении и возможностях искусственного интеллекта.

Антирейтинг цифровых обманщиков

Кто же лидеры этого печального списка? Исследование выявило четких аутсайдеров. Чаще остальных дезинформацию выдавал чат-бот Pi от компании Inflection. Однако самый поразительный прогресс в негативном смысле показал ИИ-поисковик Perplexity. Всего за год его показатель вырос с нуля до 47%, что заставляет задуматься о качестве его алгоритмов.

Знаменитый ChatGPT также продемонстрировал негативную динамику: доля ложных ответов от него увеличилась с 33% до 40%. Аналогичная ситуация и с ботом Grok — здесь показатель поднялся с 13% до 33%. На этом мрачном фоне относительно благонадежными выглядят Claude и Gemini, показавшие 10% и 17% ложных ответов. Примечательно, что год назад эти показатели составляли 10% и 7%.

От осторожности к вседозволенности

Ключевой вывод исследователей заключается не только в растущем количестве ошибок, но и в кардинальном изменении политики разработчиков. Год назад они предписывали своим цифровым детям быть крайне осмотрительными. Стандартной реакцией на сложный или спорный запрос был вежливый отказ, отсылка к этическим принципам или признание недостатка данных.

Сегодня ситуация изменилась диаметрально. ИИ-модели почти не отклоняют запросы пользователей, даже самые сомнительные. Они стремятся дать ответ на абсолютно все, что спросит человек. Эта попытка показать ИИ всезнающим, однако, имеет и обратную, крайне опасную сторону.

Уязвимость перед свежими новостями

Наиболее ярко склонность к дезинформации проявляется тогда, когда пользователи нуждаются в правде больше всего — в моменты громких и резонансных событий. Именно в периоды информационной нестабильности, кризисов или сенсаций люди массово обращаются к чат-ботам за разъяснениями. И именно в такие моменты искусственный интеллект с наибольшей вероятностью выдает непроверенные, а зачастую и откровенно ложные сведения, как показало исследование.

Парадокс технологического прогресса

Разработчики пытаются бороться с этой проблемой, наделяя ботов новыми инструментами. Доступ к веб-поиску в реальном времени и функция цитирования источников призваны повысить достоверность ответов. И иногда это действительно работает. Однако исследователи подчеркивают, что цитирование само по себе не является гарантией качества. Бот может с легкостью сослаться на сомнительный блог, недостоверное СМИ или откровенную фейковую страницу, придав таким образом ложной информации видимость авторитетности.

Отказ от принципа «не навреди», который изначально закладывался в многие модели, имеет свою цену. Стремление дать мгновенный ответ любой ценой оборачивается эпидемией дезинформации, которая распространяется очень быстро и подрывает саму идею доверия к технологиям.

Рекомендуем